みんな!AIしてる?

どうも、タナシンです(・∀・)ノ

今回はAI関連のガジェット紹介です。

その名も、

AIY Vision Kit

こちらはGoogleが出しているAI体験キットです。

第1弾として出されたのは、スマートスピーカーが自作可能なVoice Kitでした。

今回はその第2弾となるVision Kitです!

それでは早速ご紹介します。

AIY Vision Kitとは

AIY概要

AIYはお手軽にAIを体験できるDIYキットとして、Googleが出している電子工作キットです。

Raspberry Piという小型PCを利用して、AIを利用したスマートデバイスを簡単に制作することができます。

現在は2種類のキットが販売されています。

スマートスピーカーが自作可能な「Vioce Kit」

1つはVoice Kitです。

こちらは「OK Google」で有名なGoogle Homeを自分で作れてしまうキットです。

音声入力に応じていろんな反応をしてくれる生活の相棒を自分で作れるとあって、結構人気になりました。

ちなみに、私も所持しておりまして、外観は下記の記事でちょっとだけ写しております。

ちなみに私が購入したのは初期版ですので、Raspberry Pi3で動作するものですが、最近のはRaspberry Pi Zeroという更に小型のラズパイで動作するバージョンが販売されているようです。

価格は8000円くらいですね。

画像認識が手軽に試せる「Vision Kit」

そして、もう1種類のキットが、今回紹介するVision Kitです。

Vision Kitは名前の通り、画像や動画を扱うスマートデバイスを作れるキットです。

画像といえば、近年はディープラーニングがにわかに話題になり、とても人気が上がっている技術分野です。

しかし、一般的には、ディープラーニングを使うようなAIは、それなりのスペックのPCでないと動作しません。

これがGPUというものが必要だからです。

普通のノートPCですら、ディープラーニングを行うのは至難の業です。

そのため、多くの場合はスペックの良いPCを用意するか、AWSやAzureといったクラウドサービスを利用することがほとんどです。

しかし、今回紹介するVision Kitは、インターネットに接続しなくてもディープラーニングのモデルを動作させられるデバイスなのです!

これは、このデバイスにディープラーニング実行用のモジュール「Movidius」が搭載されているからです。

Movidiusはラズパイなどのエッジデバイスで学習済みのディープラーニングモデルを動作させるモジュールです。

基本的には下記のようなスティック上のモジュールなのですが、Vision KitにはRaspberry Pi Zeroに据え付けできるような形になったものが同梱されております。

このMovidiusにより、Vision Kitは非常に小型かつインターネットレスで画像認識を試せるAIデバイスとなっているのです!

そして、このVision Kitは人の顔を認識したり、物体を検出したりといった、最新のディープラーニング技術でできるようになった画像認識技術が簡単に試せてしまいます。

ちなみに価格は14000円程度です。

Vision Kit開封の儀

それでは早速ものを開けていきましょう。

まずはパッケージのスリーブを外します。

パッケージ

スリーブを外した状態

箱を開けると以下のように部品が並んでいます。

ラズパイやケーブル電子基板、外装のダンボール等々が並んでいます。

部品がきれいに固定されて並んでいるのは 、わかりやすくて良いですね!

ちなみに、箱の裏には何やらURLが記載されていました。

こちらのURLはアクセスすると下記のようなAIYサイトに飛びます。

こちらは、内容物の確認や今後の組み立て・デモ方法が記載されておりますので、お手元のデバイスでアクセスしてください。

サイトはすべて英語というのがネックですが、そこはGoogle翻訳を一括翻訳すれば問題なしです。

Vision Kit組み立て

それでは早速組み立てていきたいと思います。

内部モジュールの作成

まずは、カメラなどが搭載される内部モジュールを作成していきます。

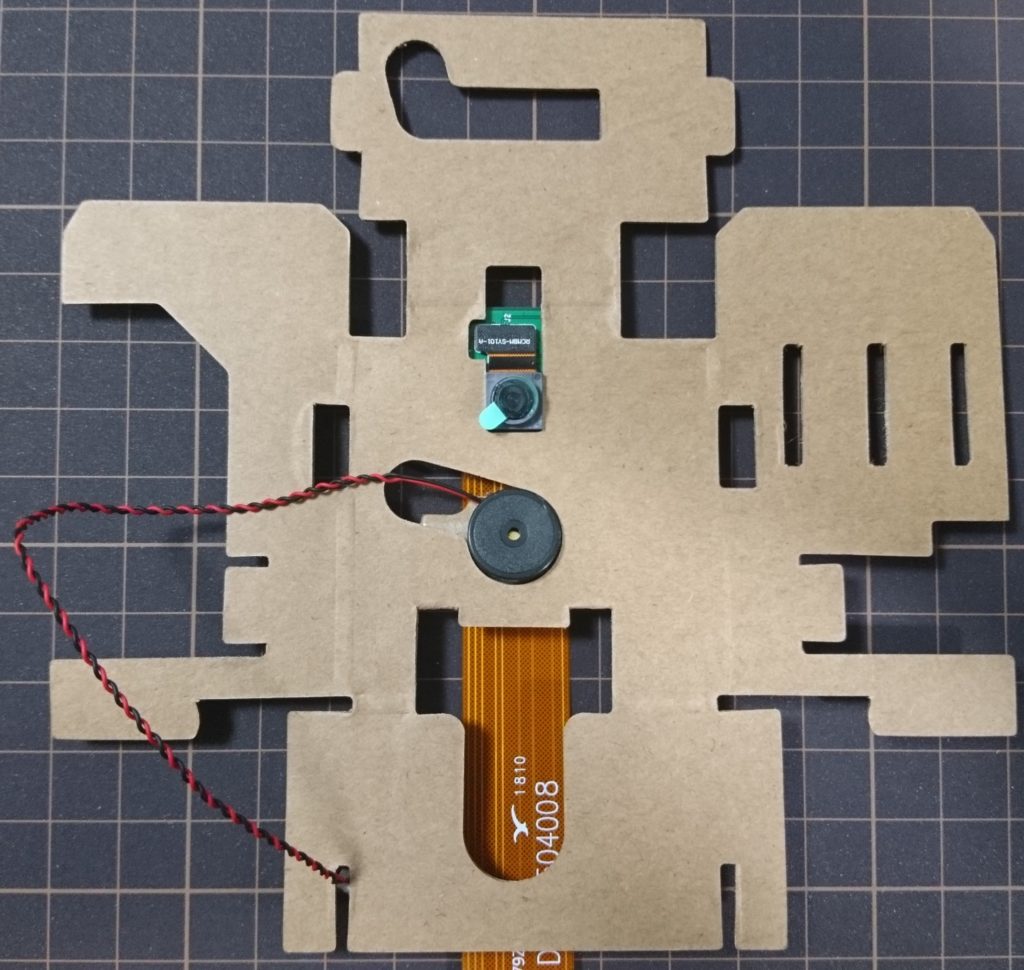

最初に使うのはカメラモジュール、ブザーモジュール、配線ケーブル、内部ケースです。

写真では袋に入りっぱなしですが、左上の袋がカメラモジュールです。

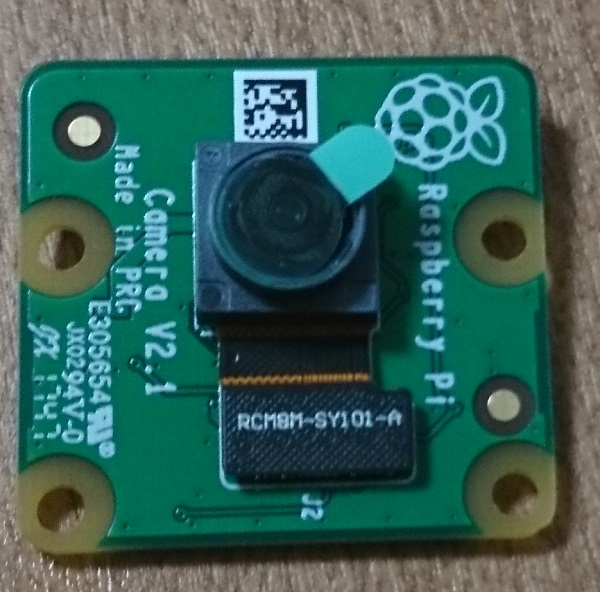

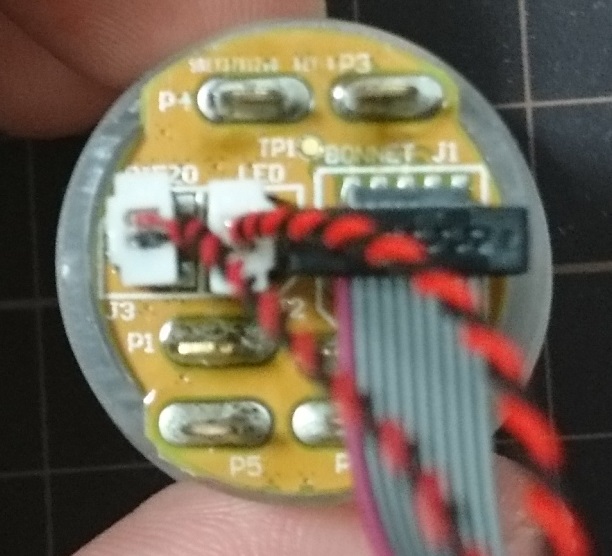

ちなみに、カメラモジュールは以下のような感じです。

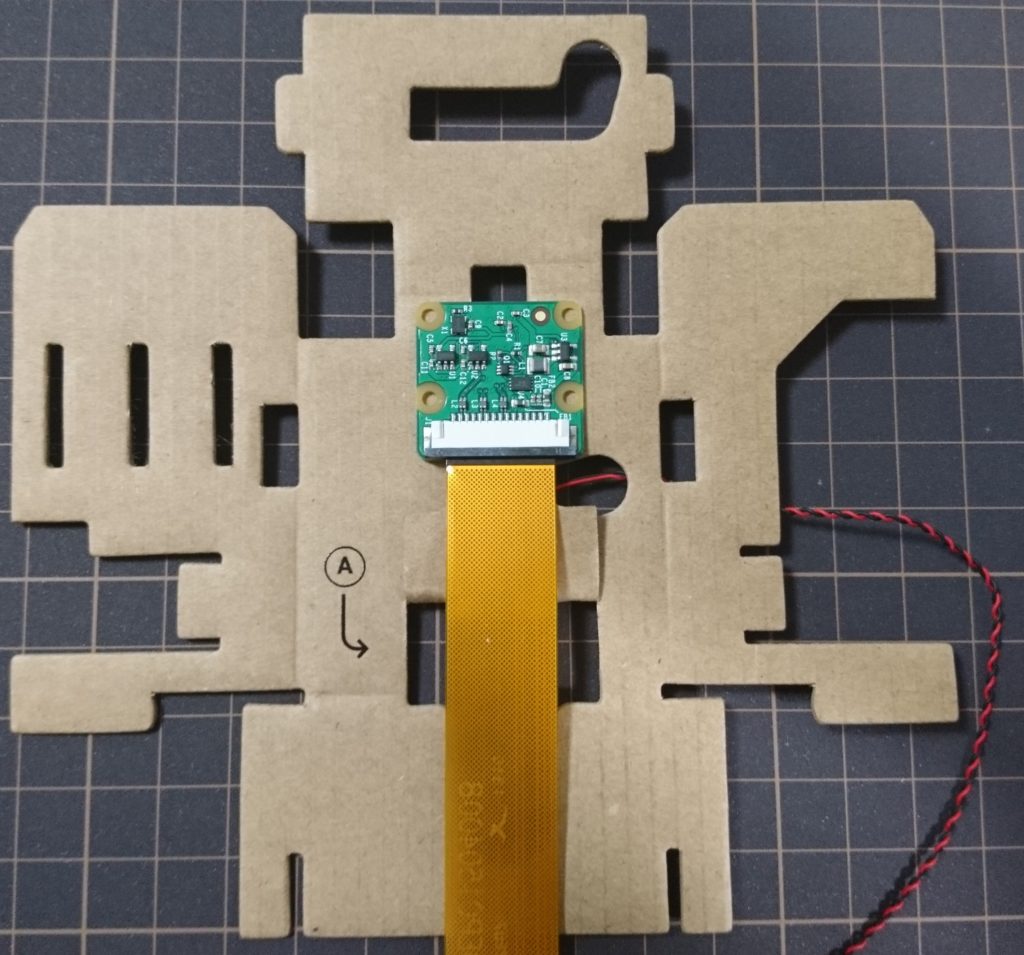

カメラモジュール表

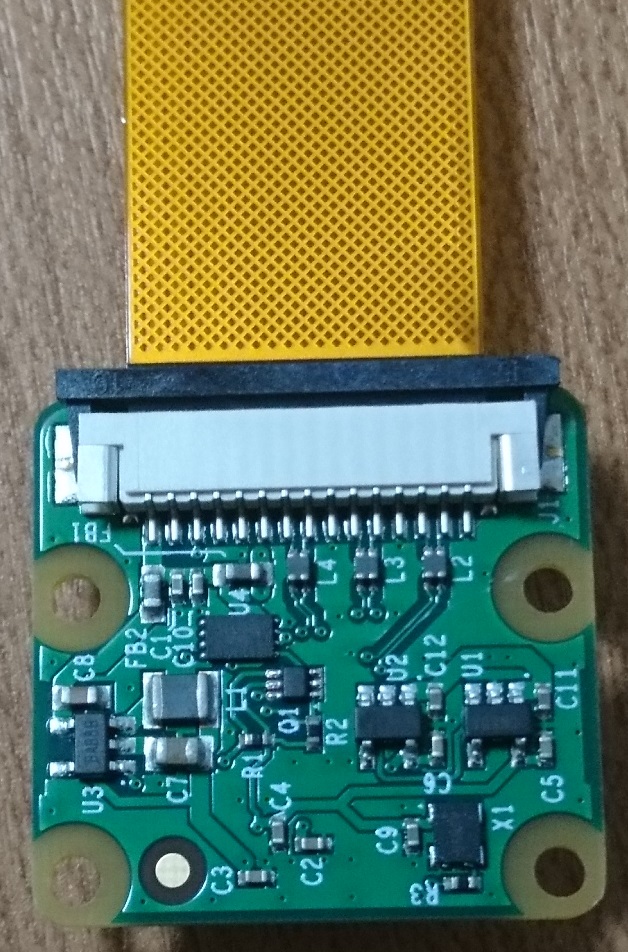

カメラモジュール裏

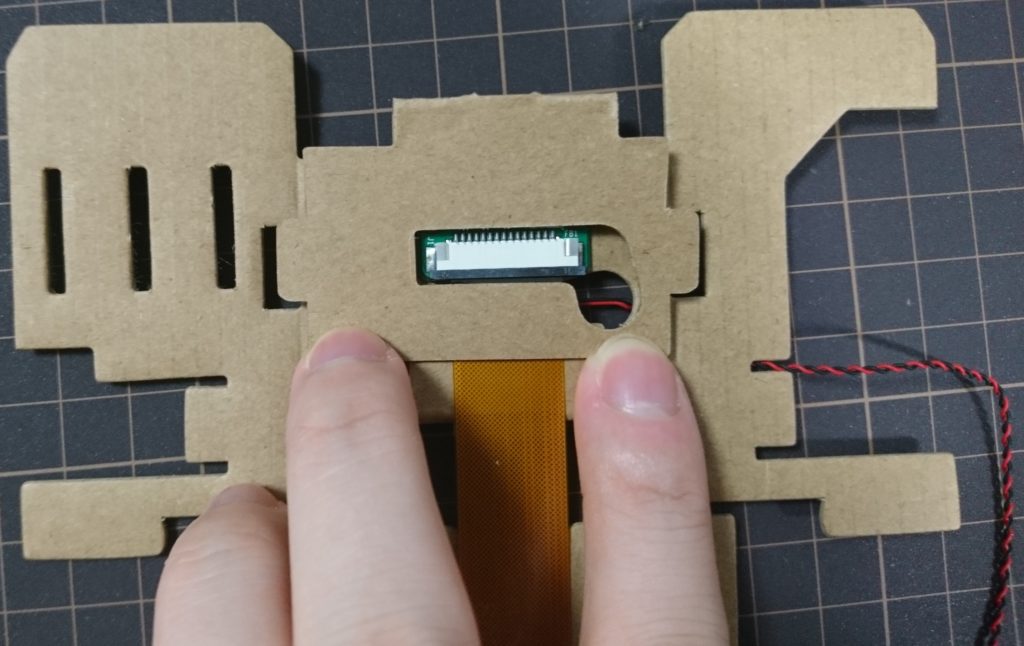

カメラモジュールの裏側の上にある黒と白の部分に、カメラ用のへーブルを差し込みます。

黒い部分を一度上に引き、ケーブルを差し込んでから、再度黒い部分を押し込んで固定します。

ケーブルの向きに注意してください。

最込口開口

ケーブル差し込み

ケーブル固定

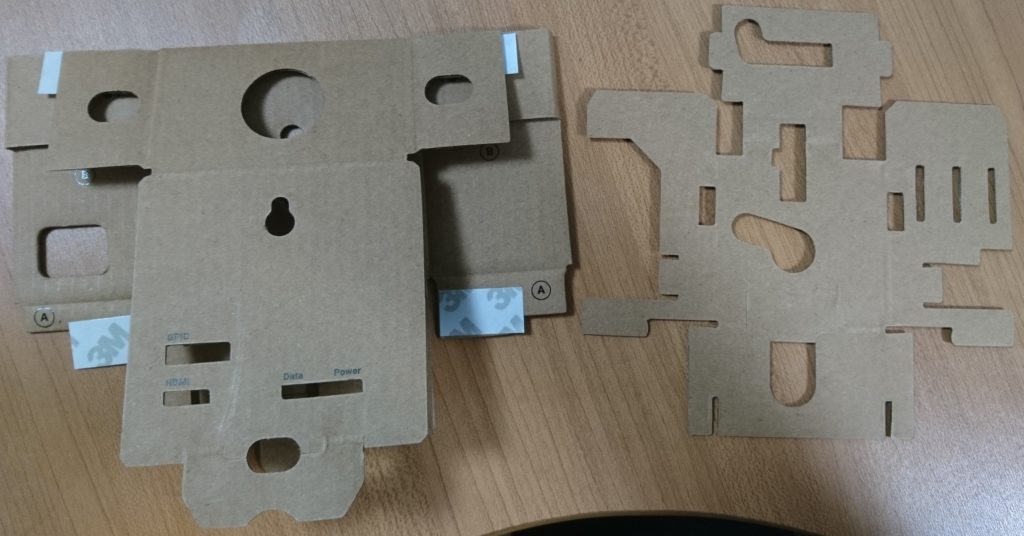

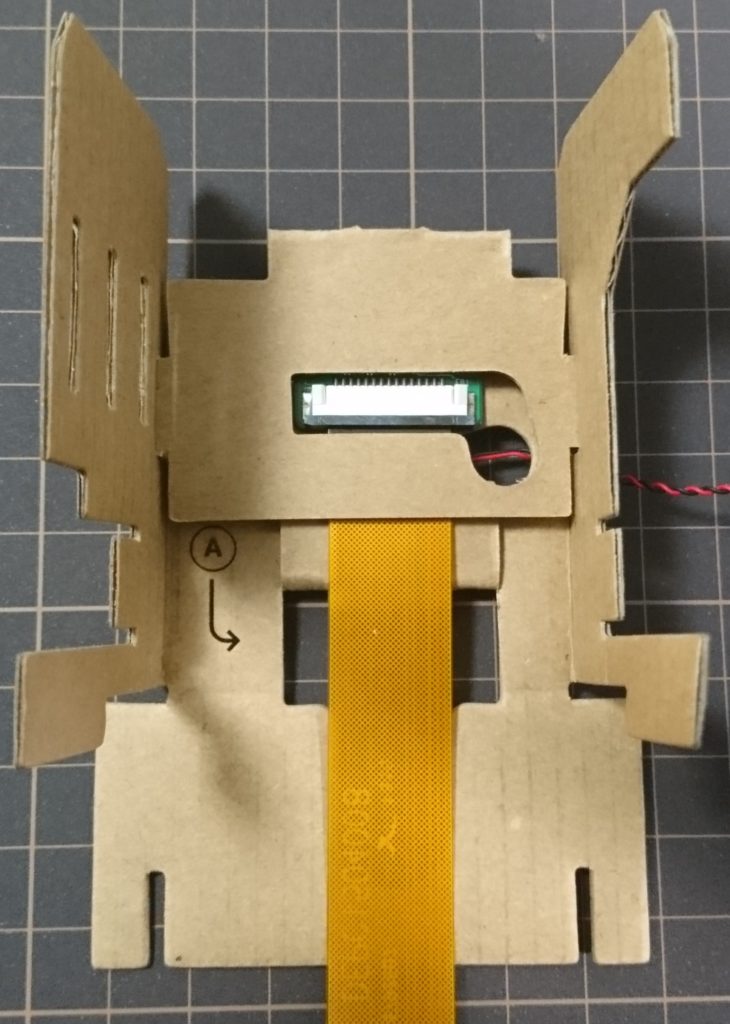

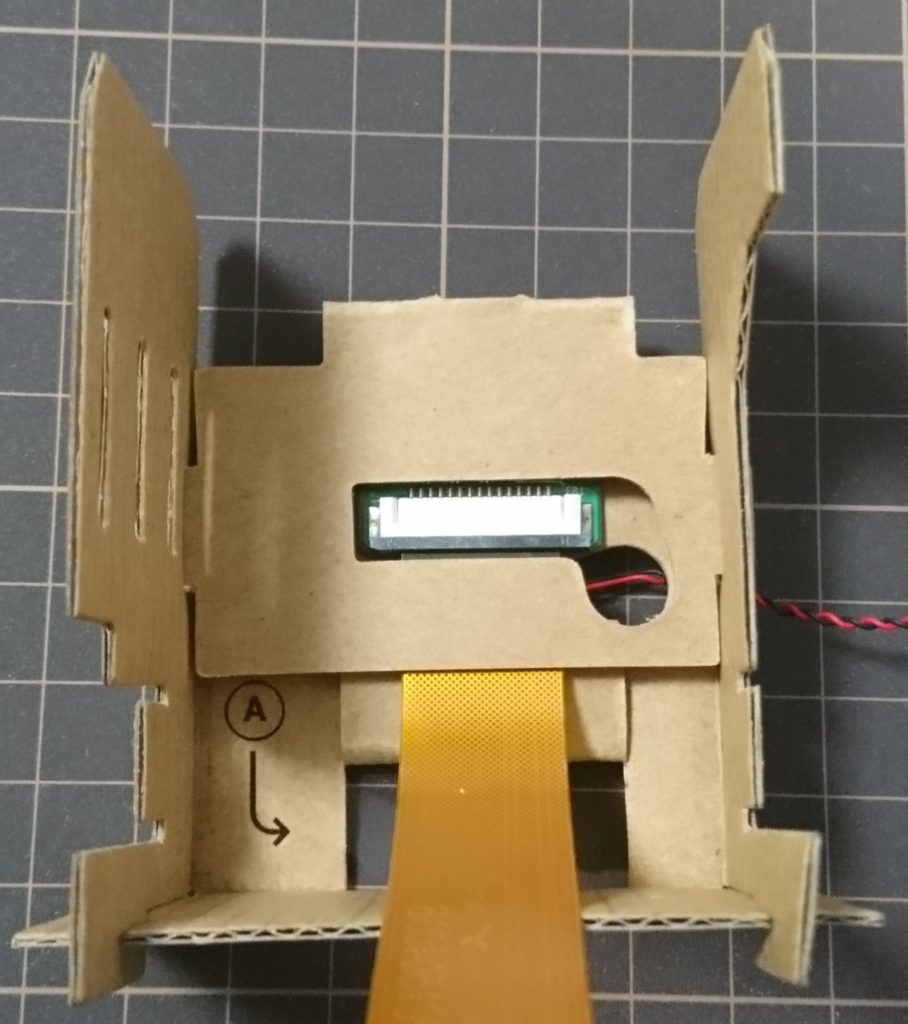

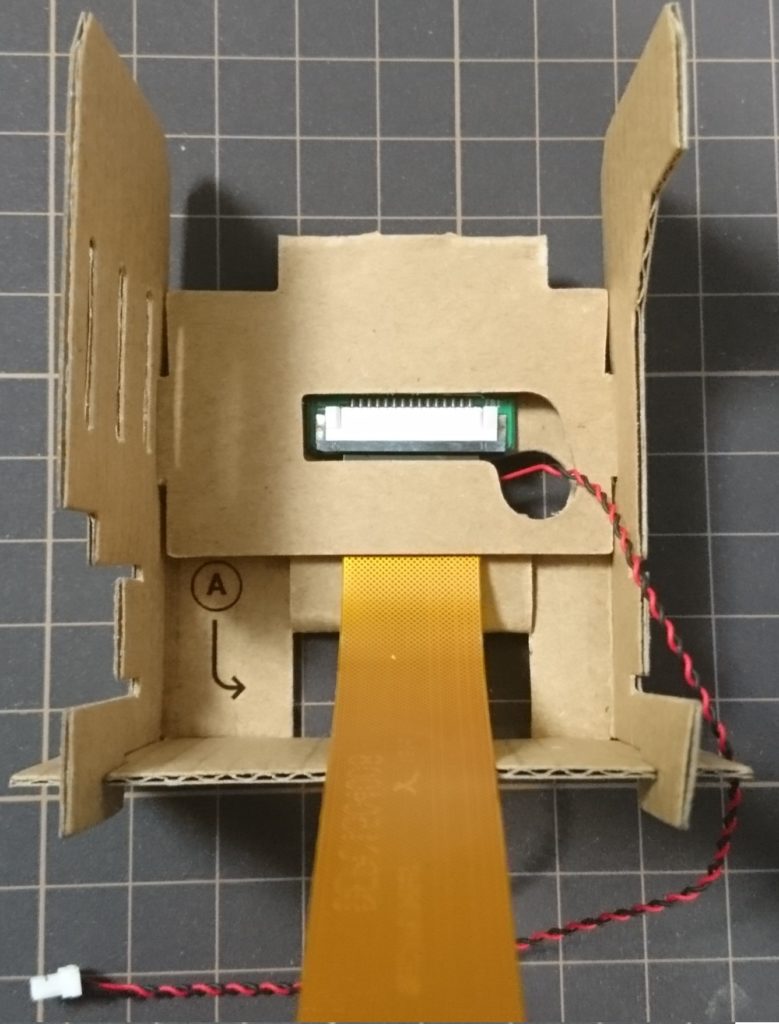

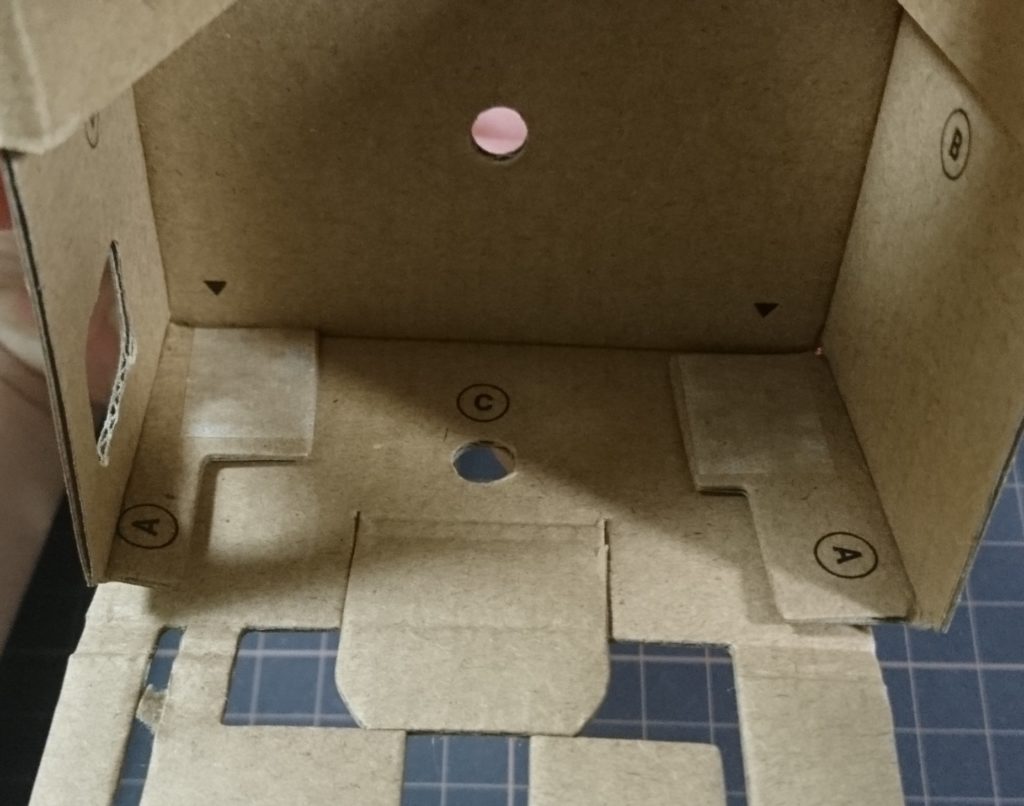

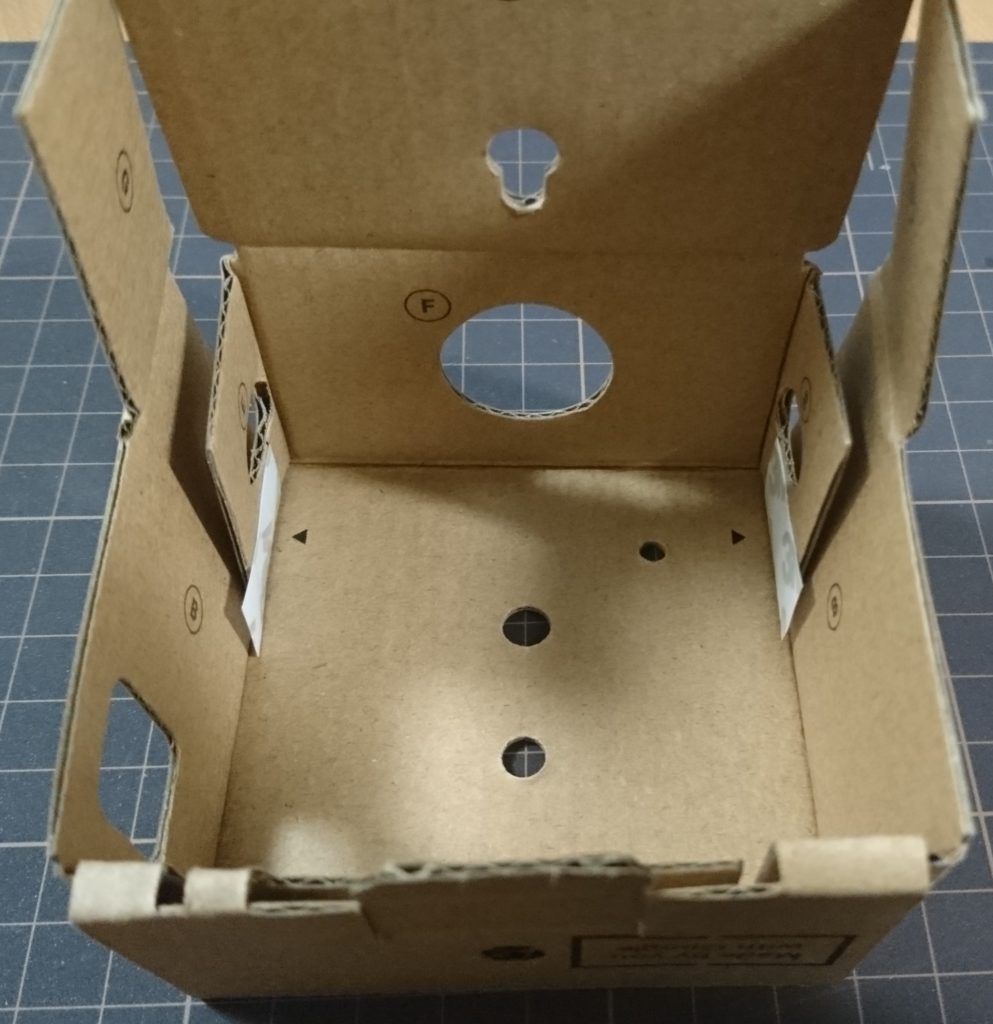

次に箱側は作っていきます。

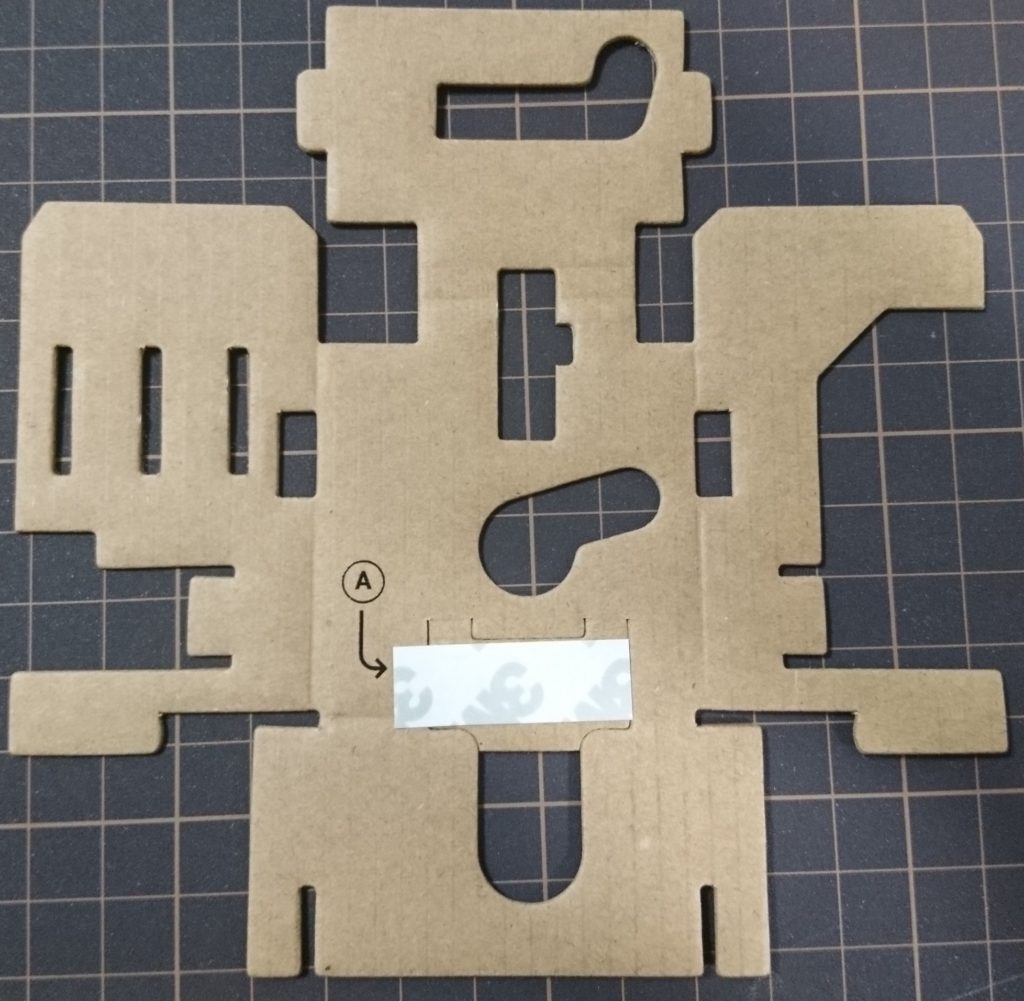

使うのは下記ダンボール部品の右のものです。

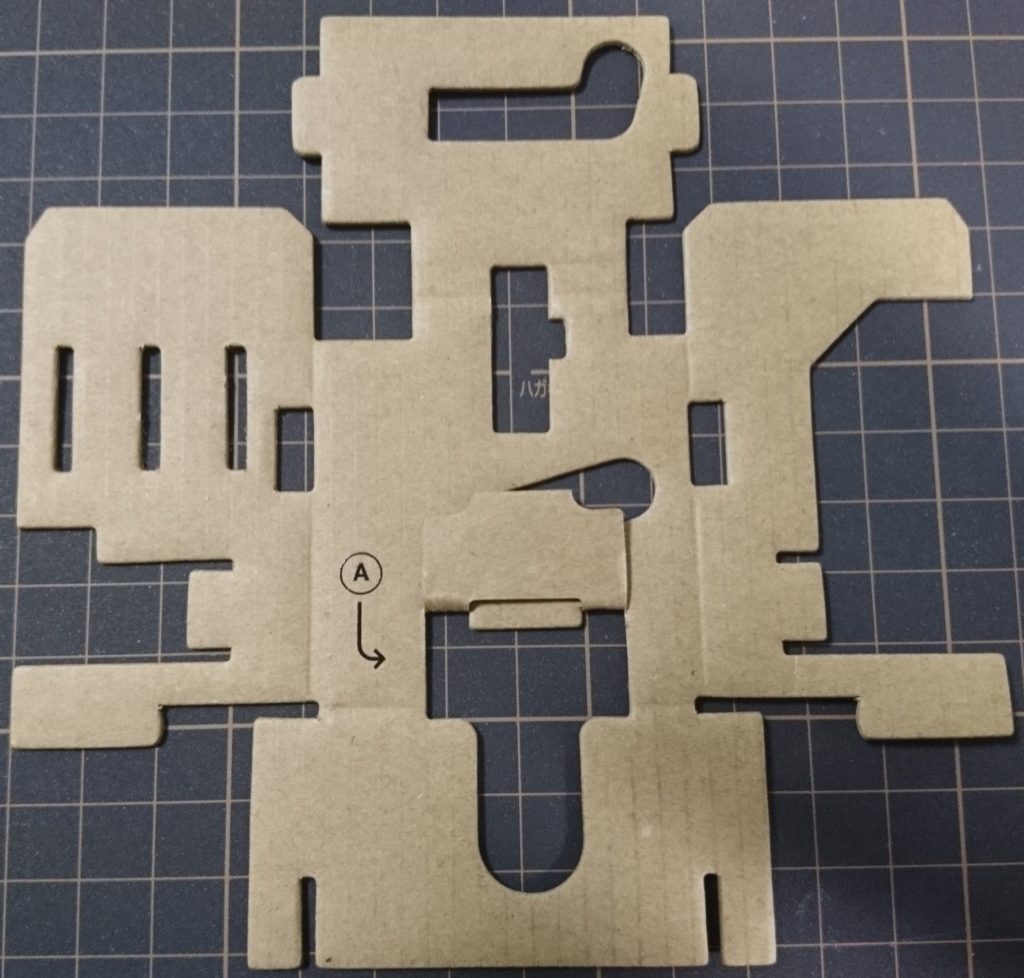

まずは正しい向きでダンボールを置きます。

ダンボール中央の両面テープを剥がし、折り曲げて貼り付けます。

折り曲げた様子

逆面から見た様子

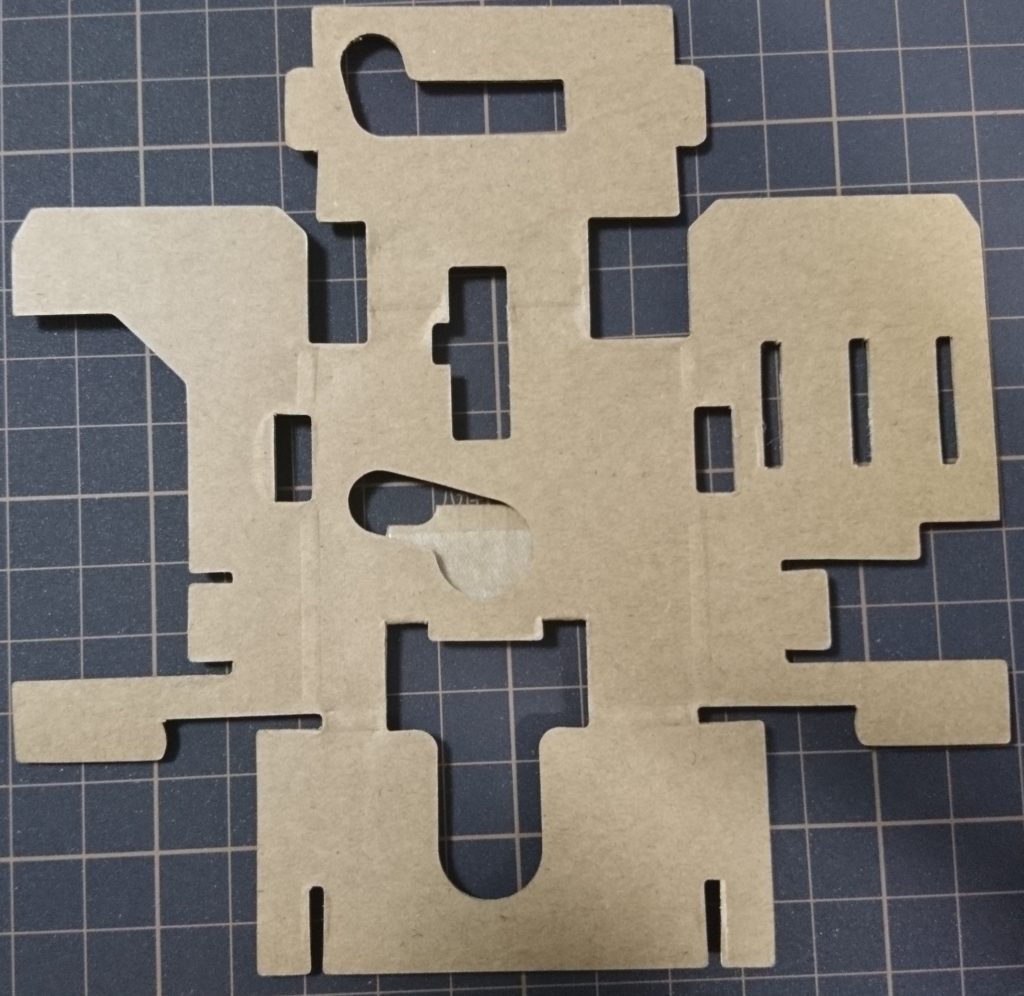

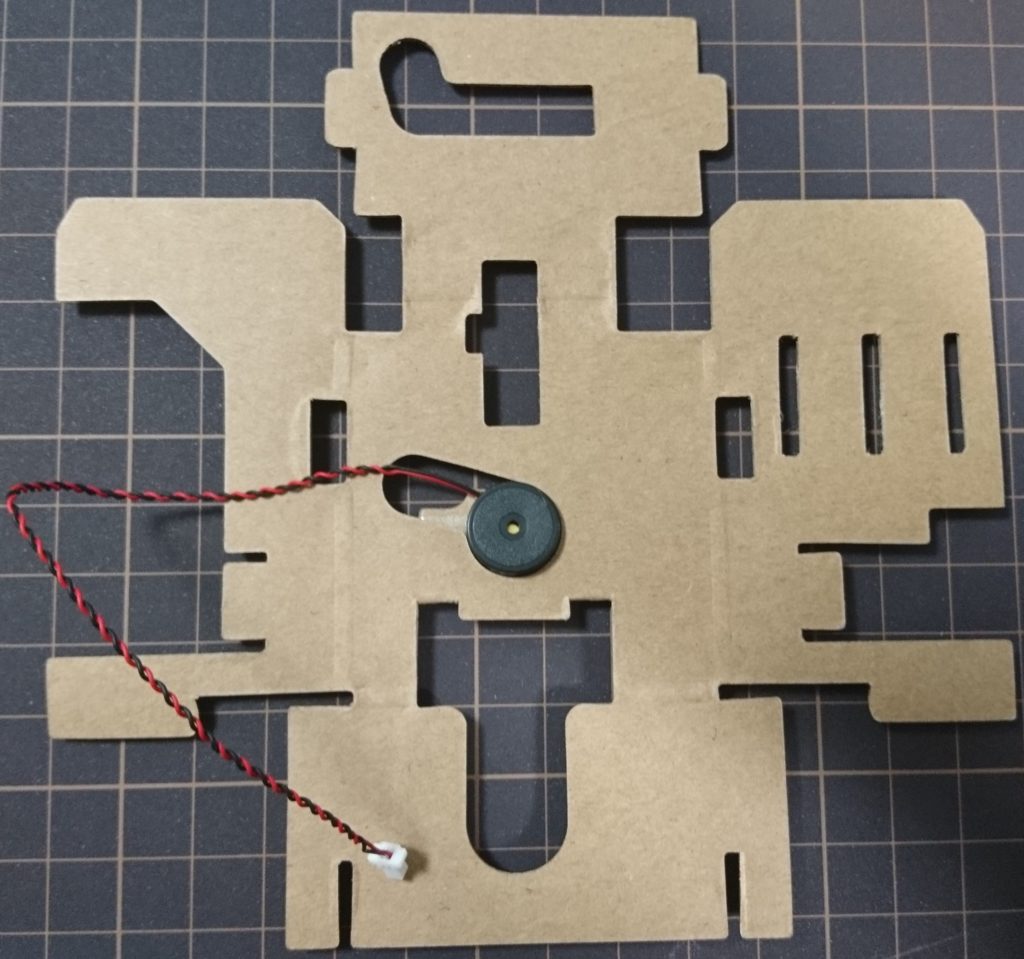

逆面から見た様子のまま配置し、ブザーモジュールを両面テープの位置に配置します。

次に、ブザーの上側にカメラモジュールを配置します。

カメラモジュール配置

カメラモジュール裏側

カメラモジュールが裏側になっている状態で、カメラモジュールの上部分を折り曲げます。

その後、左右と下部も折り曲げてから、カメラモジュールの右下の穴からブザーモジュールのケーブルを通します。

1.カメラ上部折り曲げ

2.左右折り曲げ

3.下部折り曲げ

4.ブザーケーブル配置

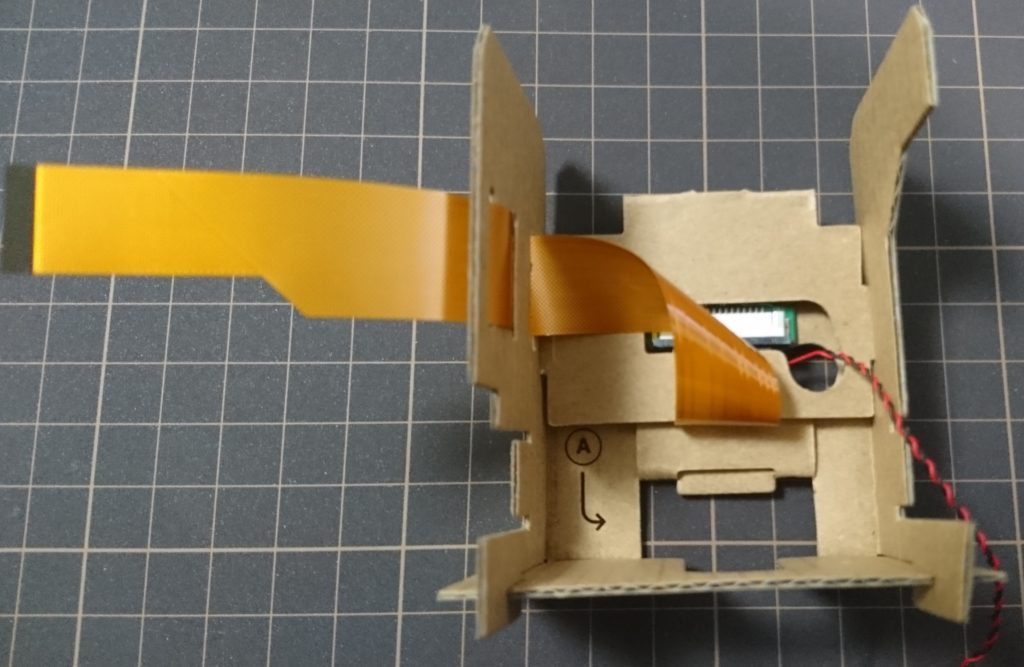

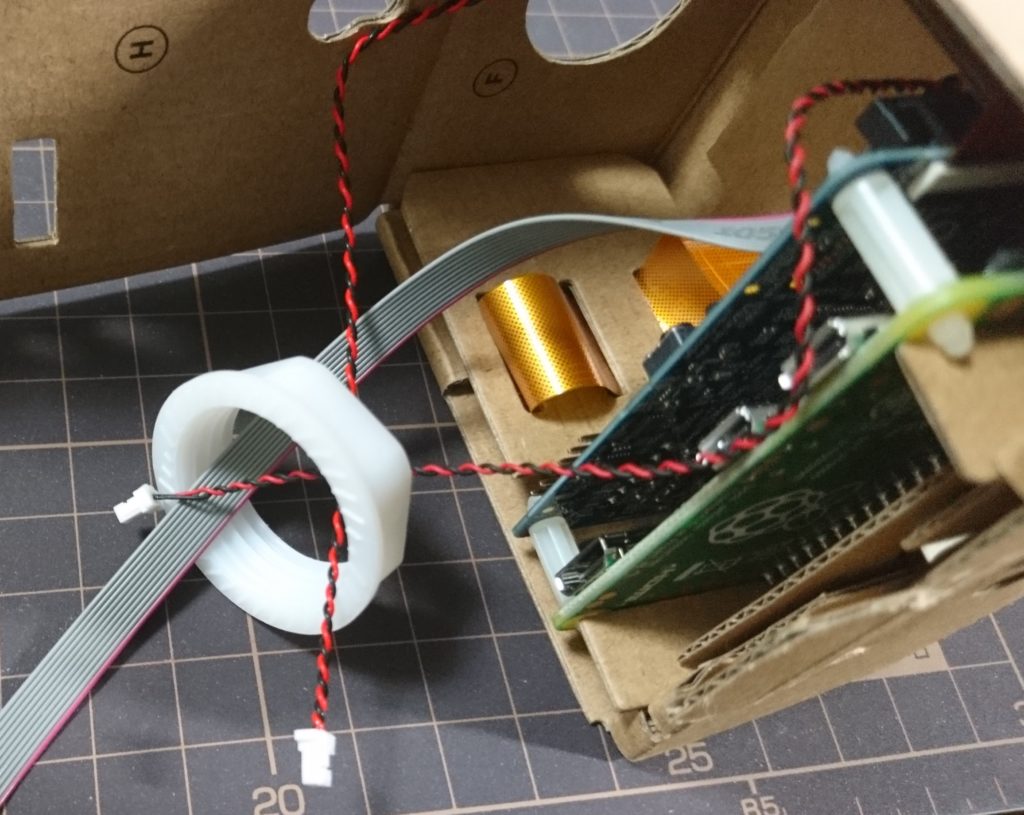

次に、箱の側面にカメラケーブルを通し、配線します。

配線後

配膳後側面

これで内部モジュールは完成です。

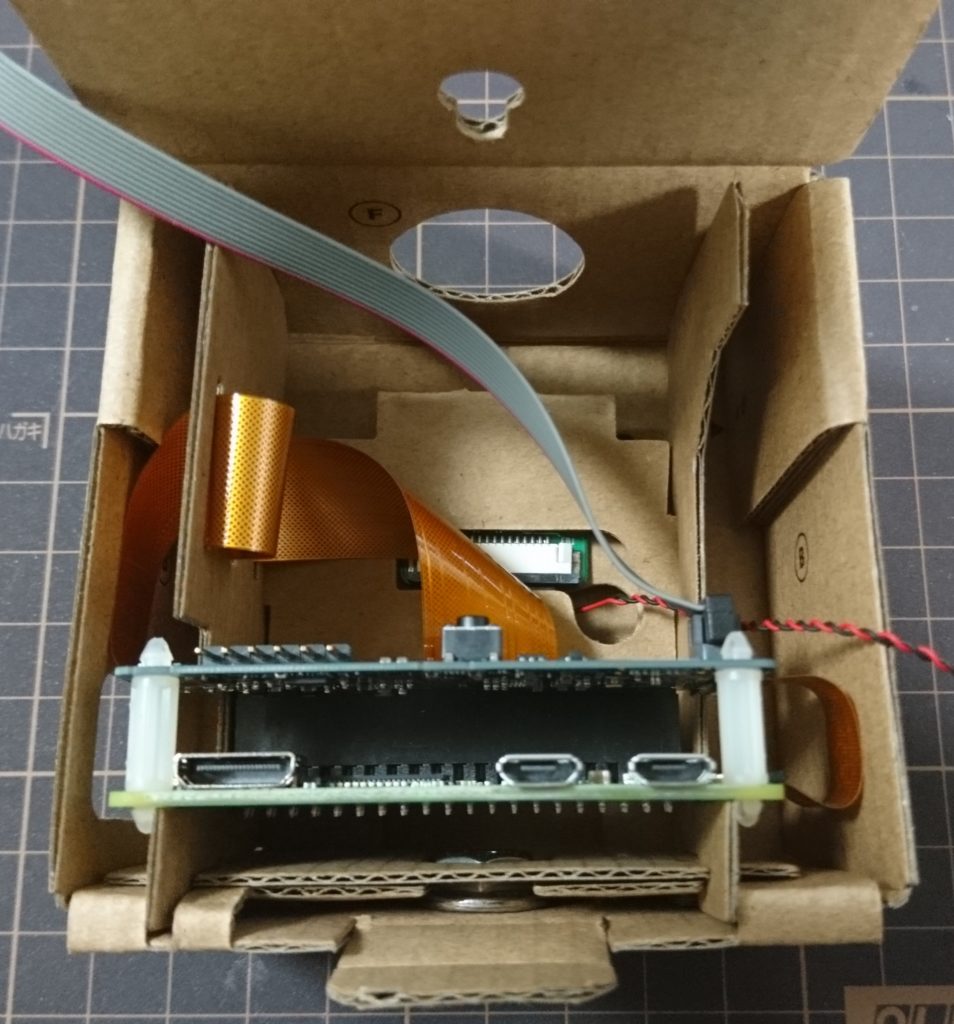

基盤の作成・配置

ここでは基盤を作成していきます。

基盤といっても、ラズパイとVisionモジュール(Movidius)を配置する作業です。

使う部品は以下です。

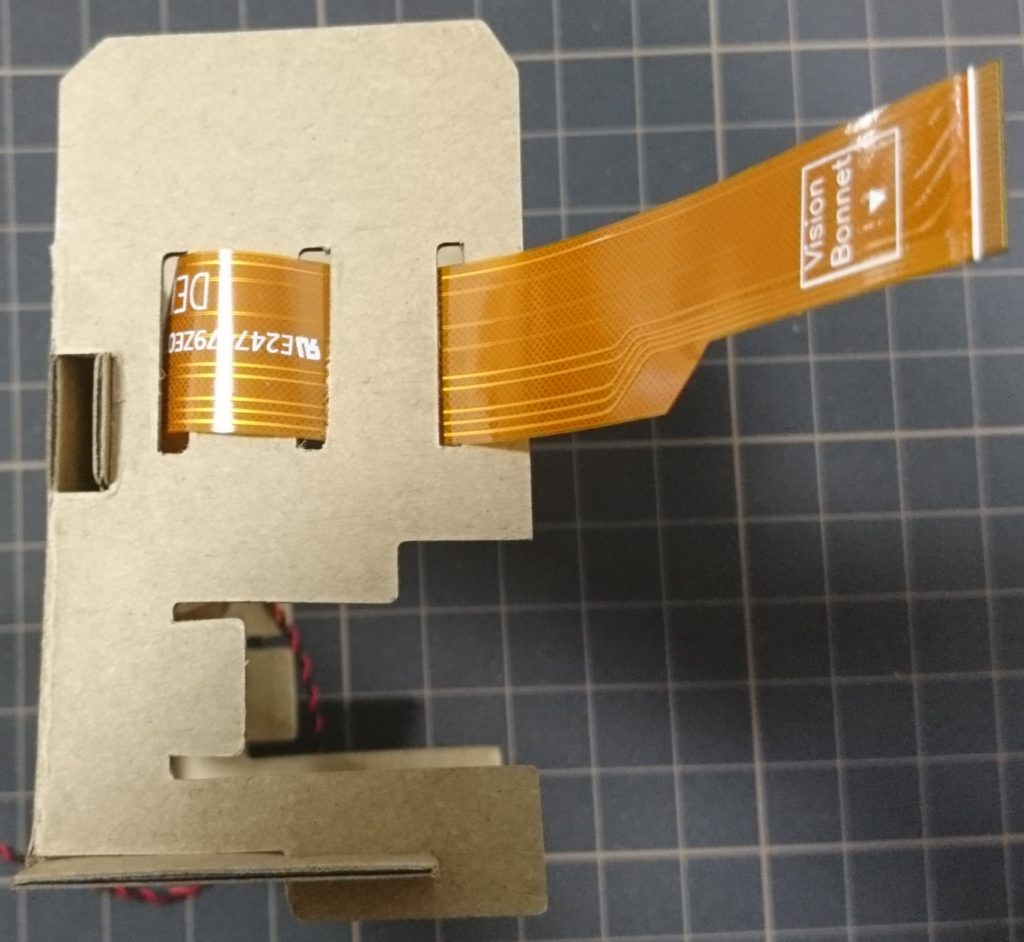

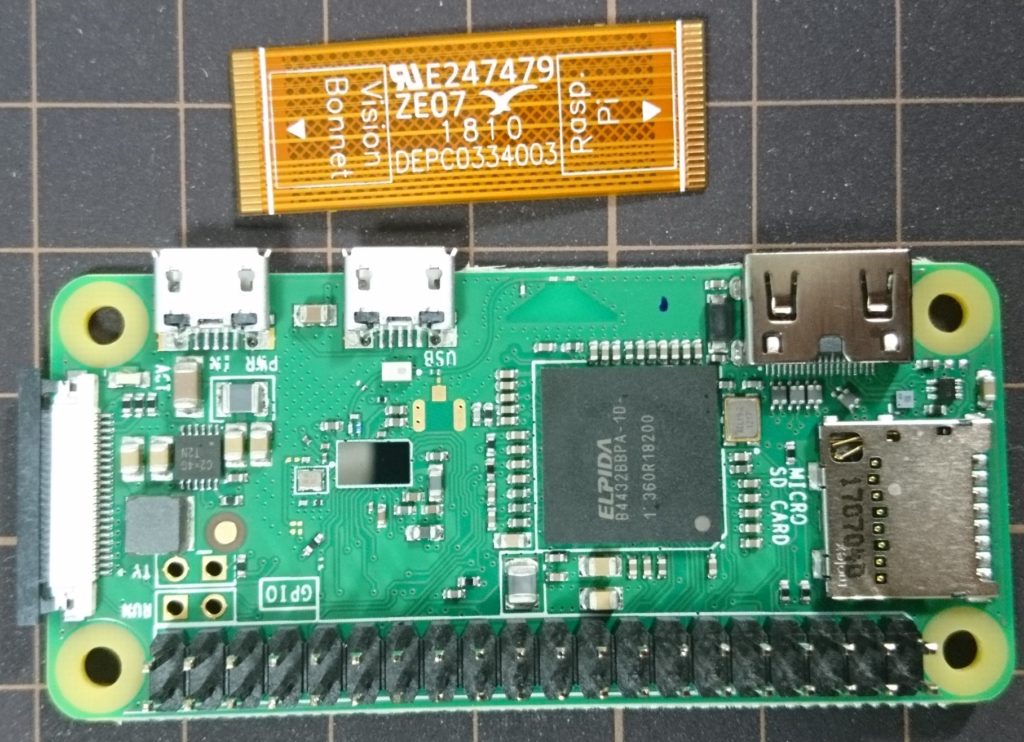

まずはラズパイにケーブルを差し込みます。

所定の向き・位置からケーブルを差し込みます。

ラズパイ側にはカメラモジュール同様、白い差し込み部があります。

ここに差し込んで、黒い部分を押し込んだら、ケーブルは固定されます。

ここでもケーブルの向きに注意してください。

ラズパイとケーブル

差し込みして固定

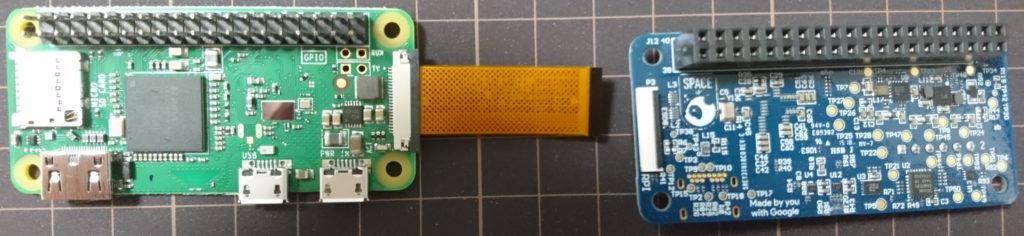

次にラズパイにつないだケーブルの逆側をVisionモジュールに接続します。

こちらのケーブルの固定は黒い部分を押し込むのではなく、倒すことで固定します。

接続向き

ケーブル固定

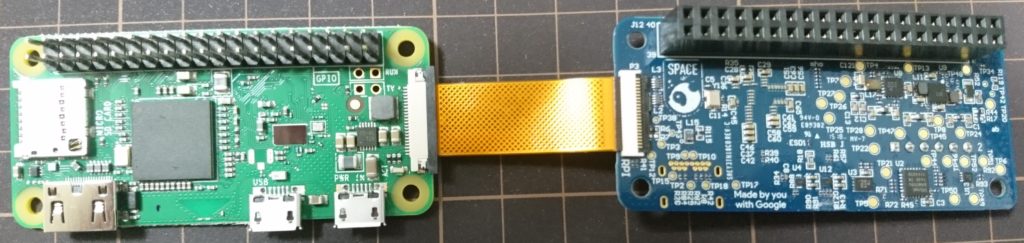

次に、ラズパイの穴にスペーサを差し込みます。

付ける位置はHDMI端子などが付いている長辺両端です。

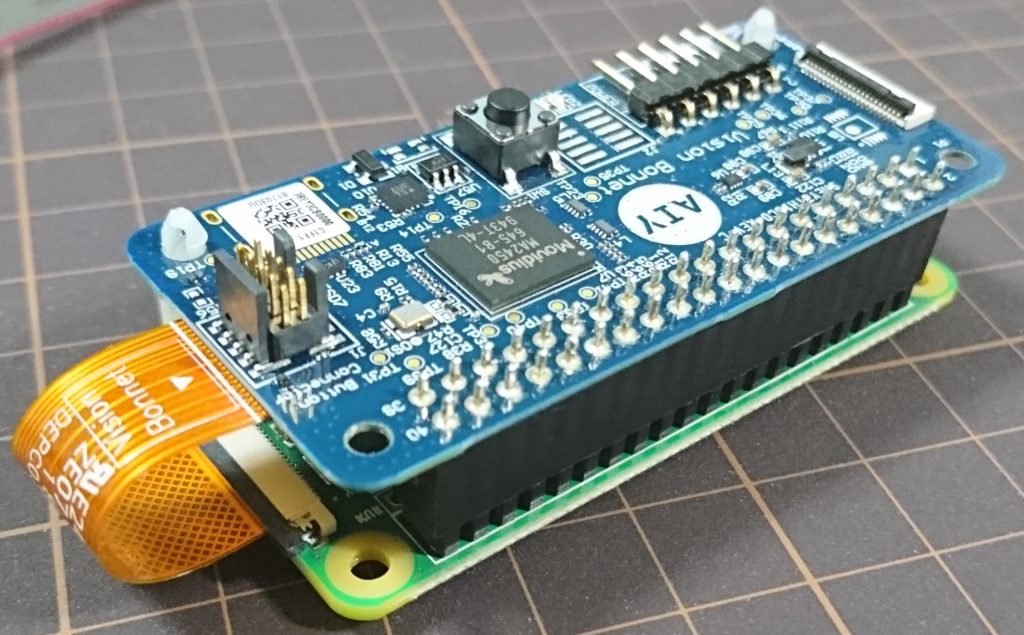

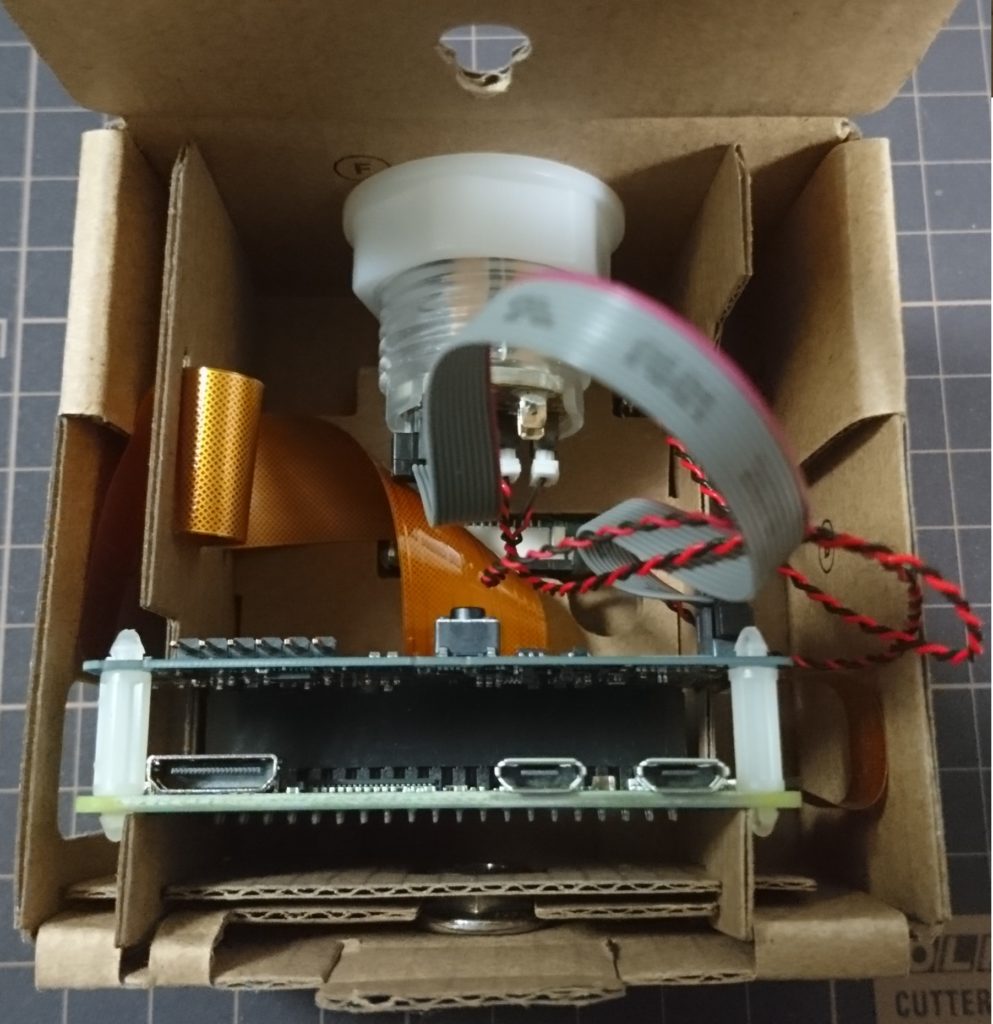

ここまでできたら、後はVisionモジュールをラズパイに差し込みます。

スペーサももちろんVisionモジュールの穴に差し込み、固定します。

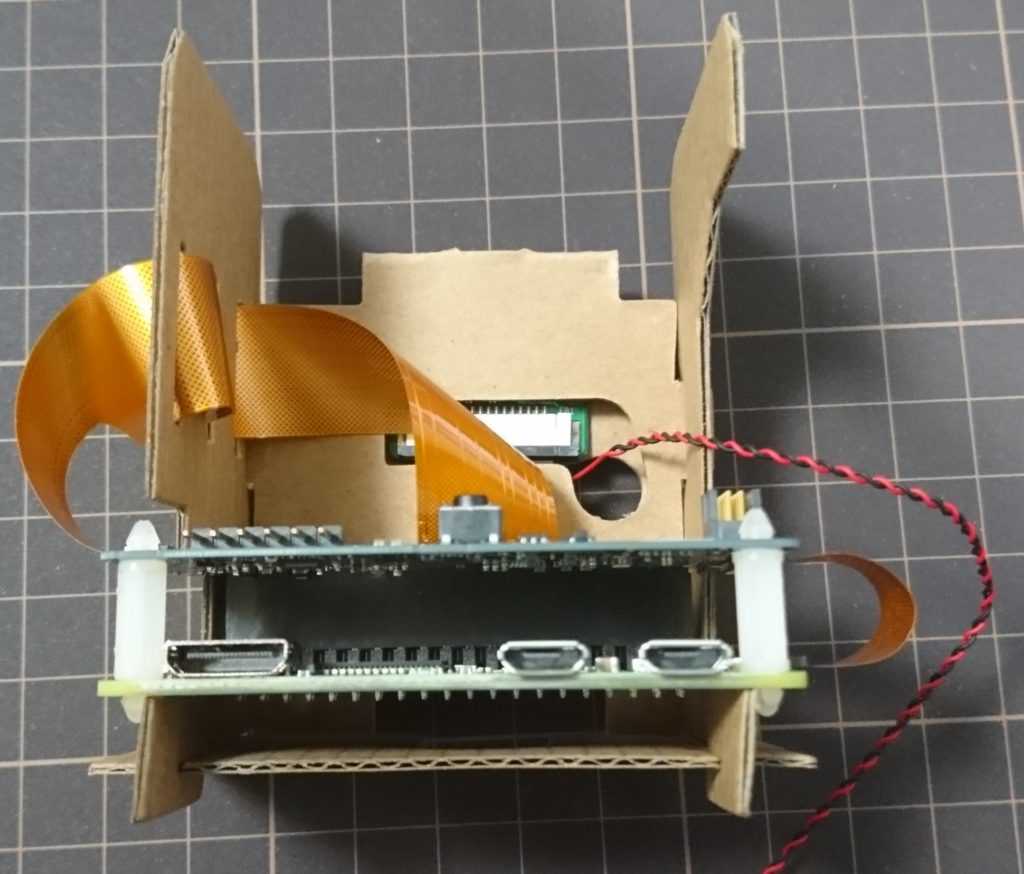

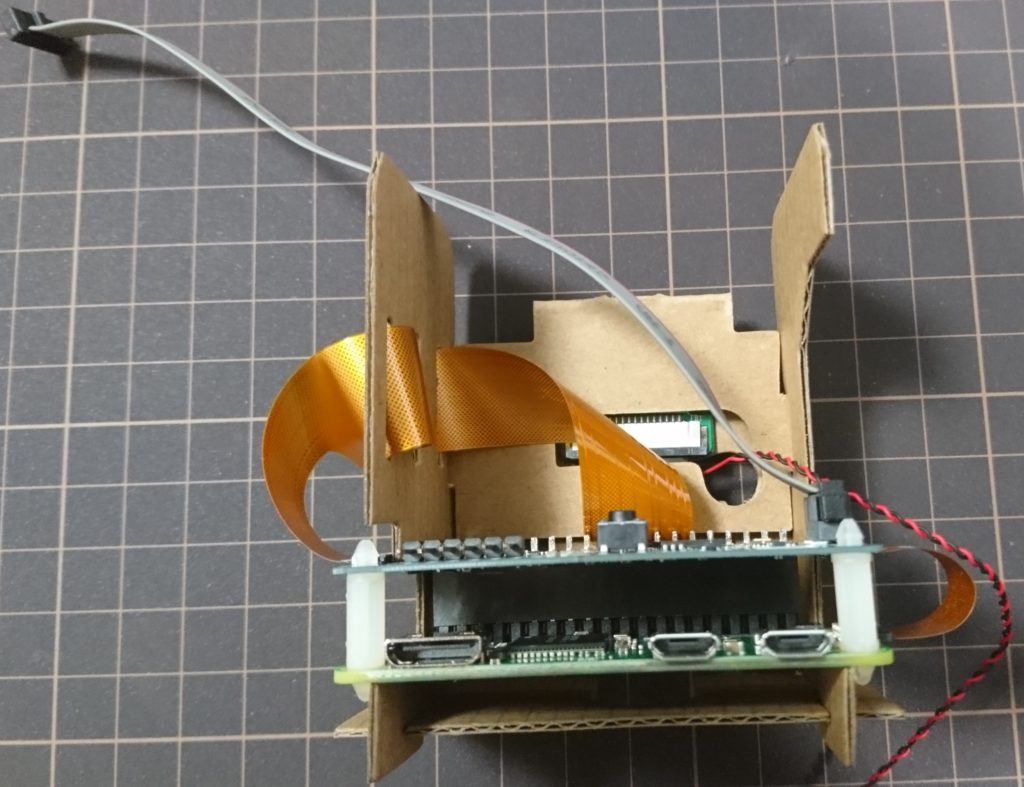

基盤配置

逆向きから見た図

ここまでで基盤の作成は終了です。

次にこの基盤を内部モジュールに配置していきます。

内部モジュールの下部に基盤を差し込みます。

差し込む向きに注意してください。

差し込めたら、右側のピンにコネクタを差し込みます。

基盤配置

コネクタ差し込み

ここまでが基盤の作成・配置になります。

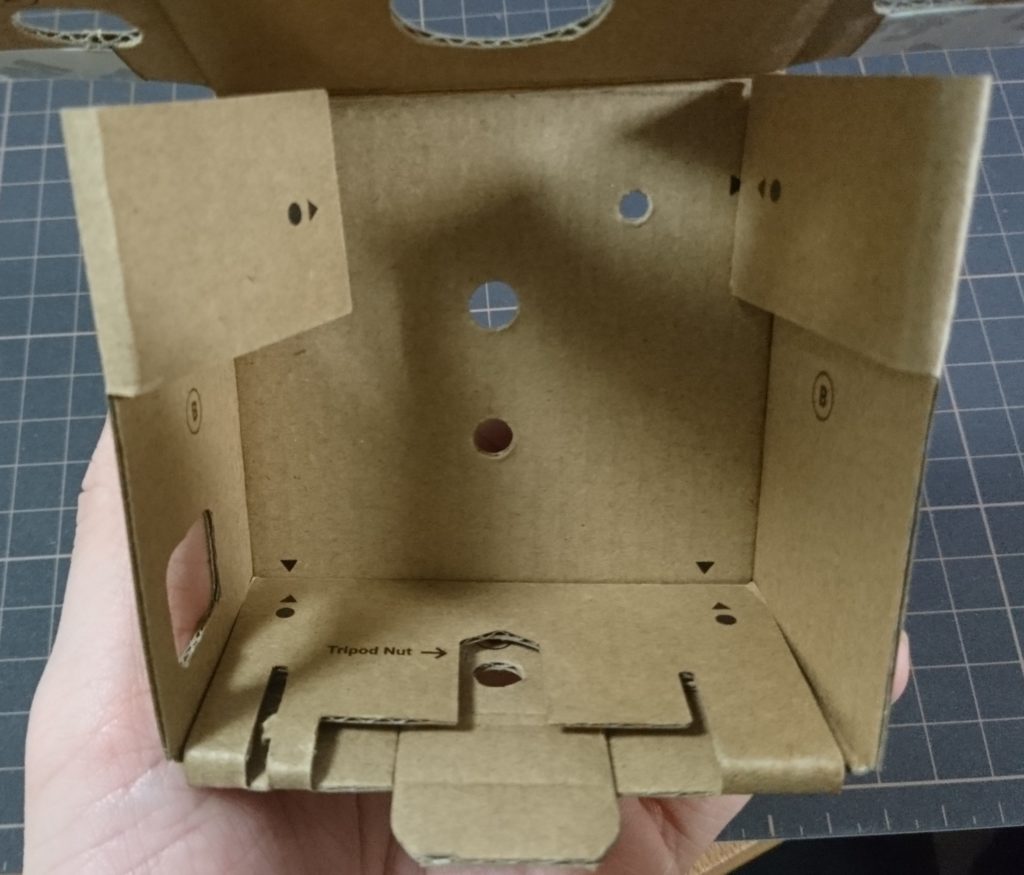

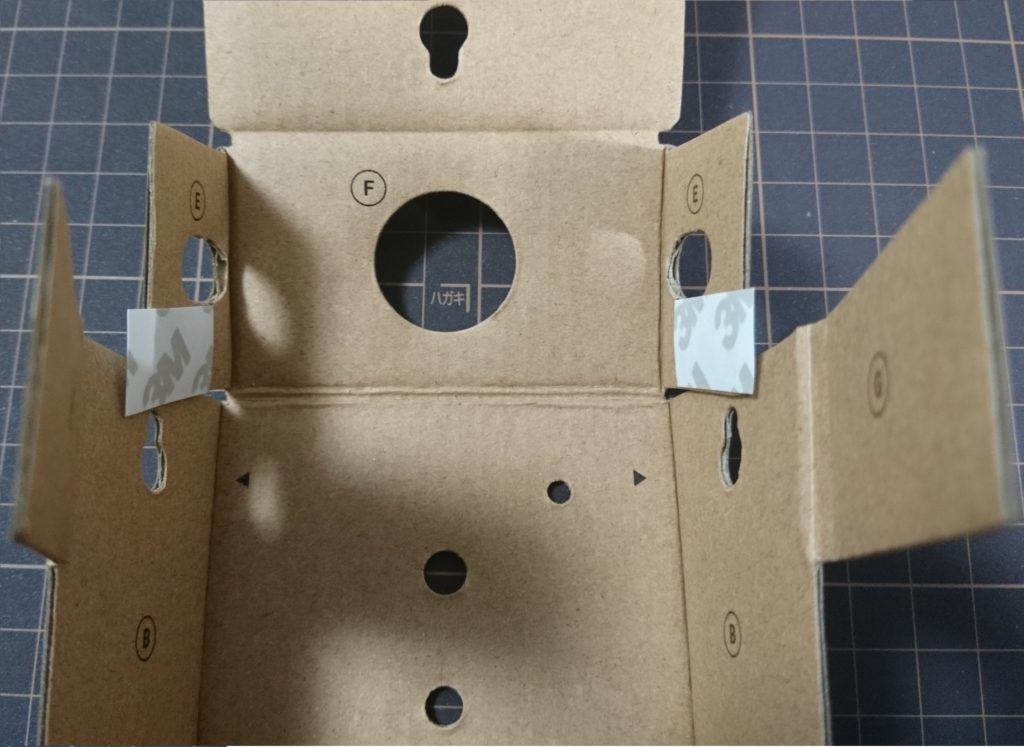

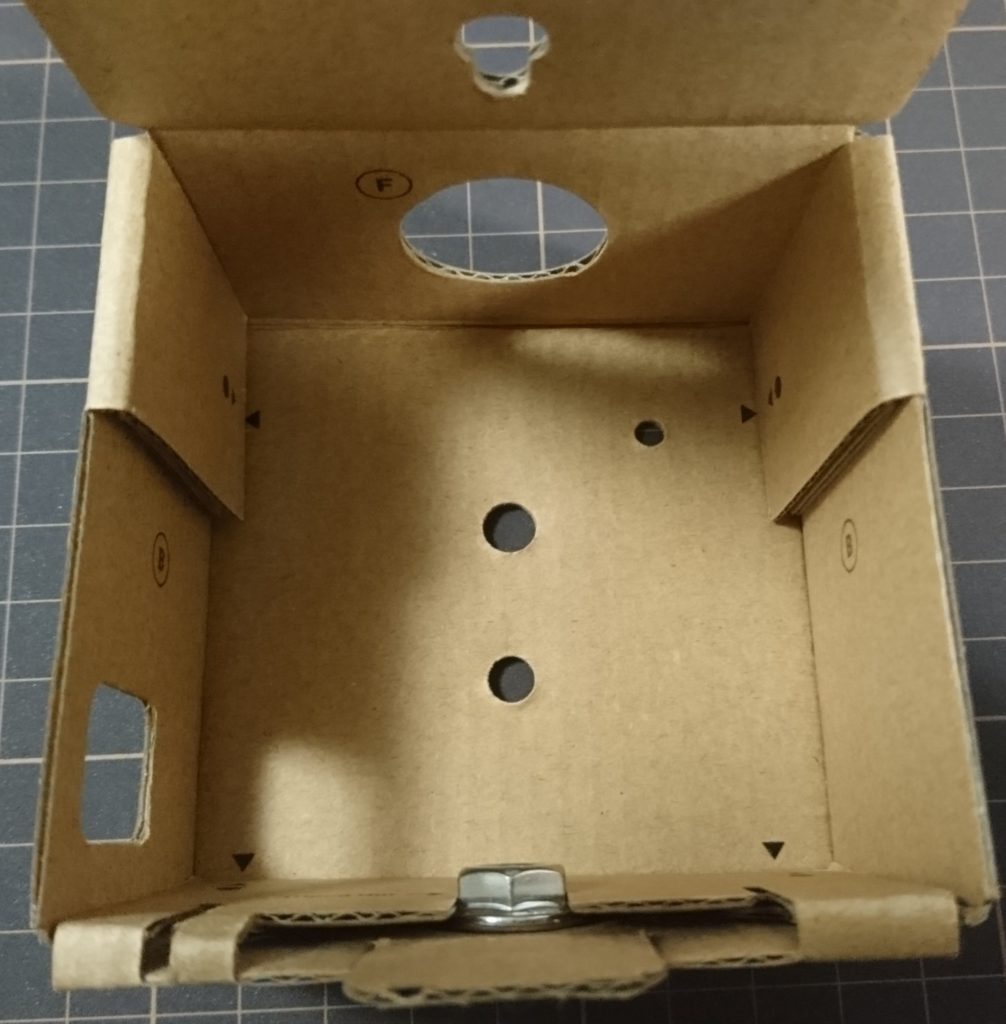

外箱の作成

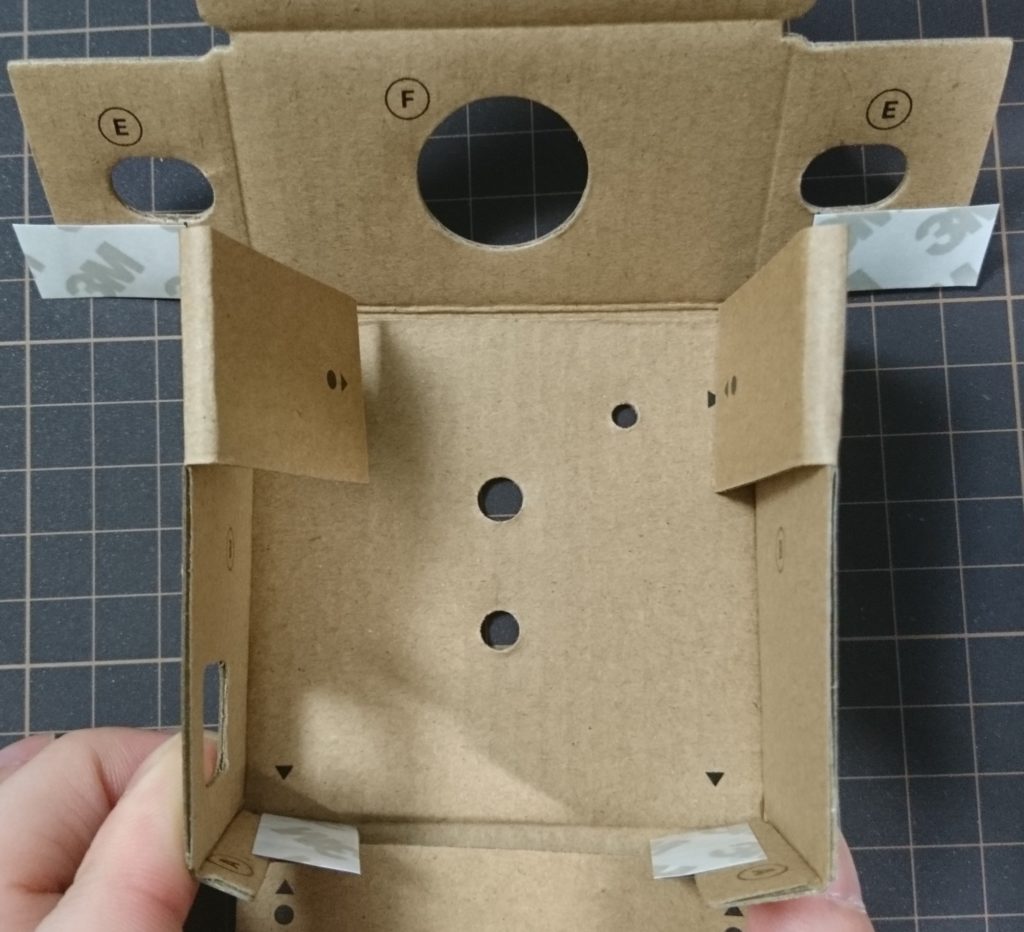

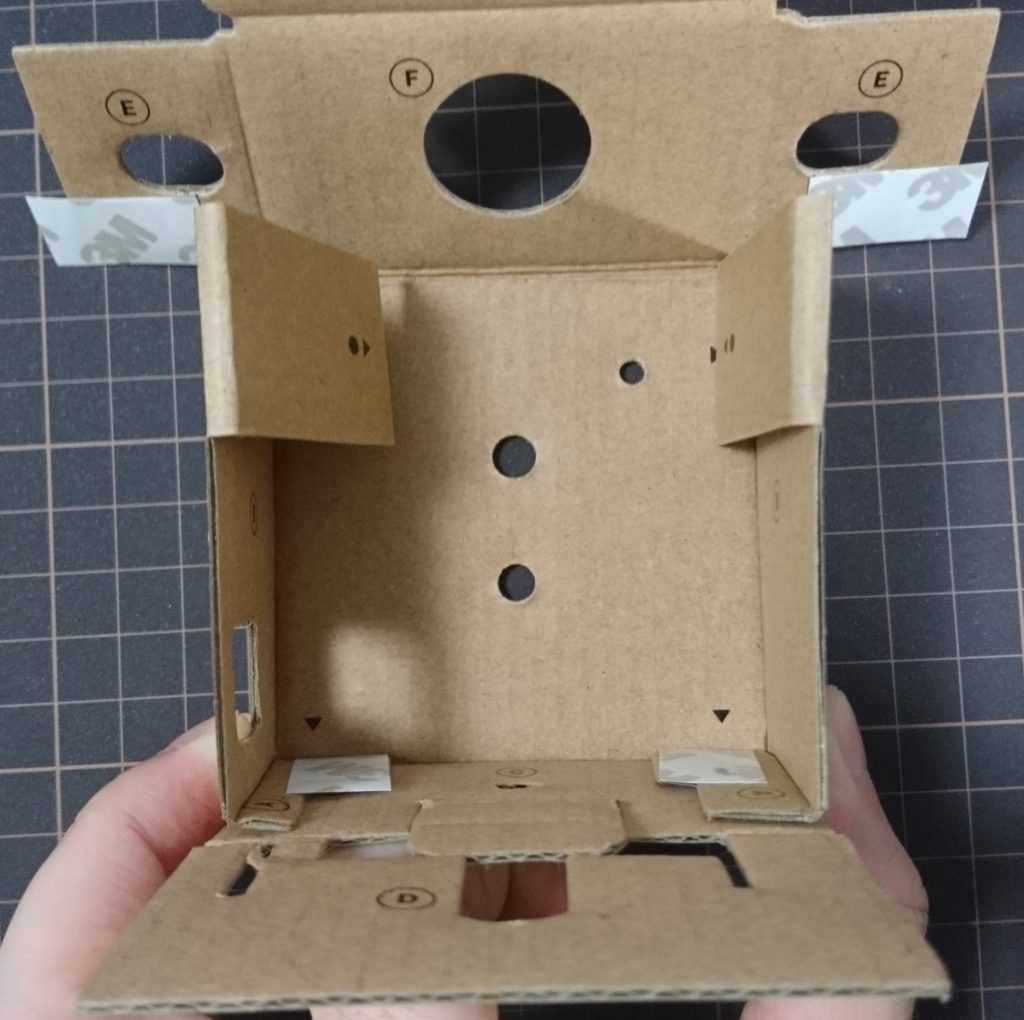

モジュールが入る外箱を作成します。

使うのは下記の部品です。

箱は一度開いてから、左右を折ります。

開いた図

左右折り曲げ

次に底面を折り曲げて、下部左右の両面テープを外し、更に底面を折り込んで両面テープで固定します。

底面折り曲げ

両面テープ外し

底面折り込み

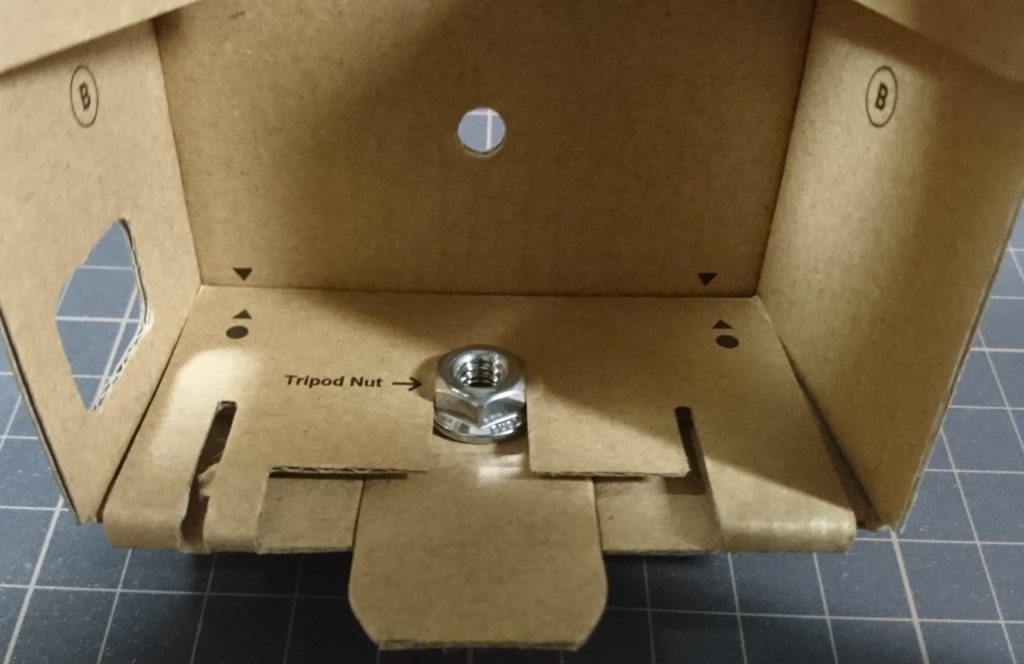

そして、底面のくぼみにスライドさせるように六角ナットをはめ込みます。

次に、左右の上部の折り曲げられている部分を一度開き、上面を折ります。

そして上面左右の両面テープを外し、左右の折り曲げられていた部分を戻して、両面テープで固定します。

左右を開く

上面を折り曲げる

左右を戻し、固定

ここで、外箱は一旦作業完了です。

内部モジュールの配置

次に、外箱の内部に内部モジュールを配置していきます。

内部モジュールの足が、外箱の底面の溝にはまるように差し込みます。

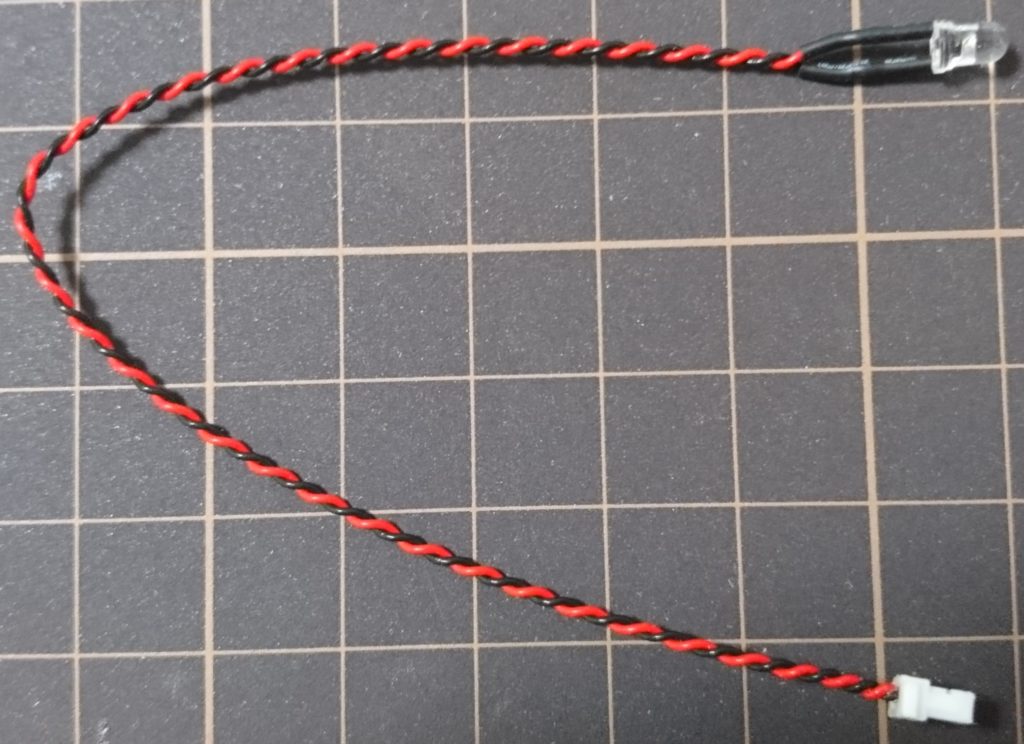

LEDの配置

外箱の表面にある穴にLEDを配置します。

使うのは以下の部品です。

LEDモジュール

LEDソケット

まずは外箱の表面からソケットを挿入します。

次に、外箱の内側から、ソケットに対してLDE電球を差し込みます。

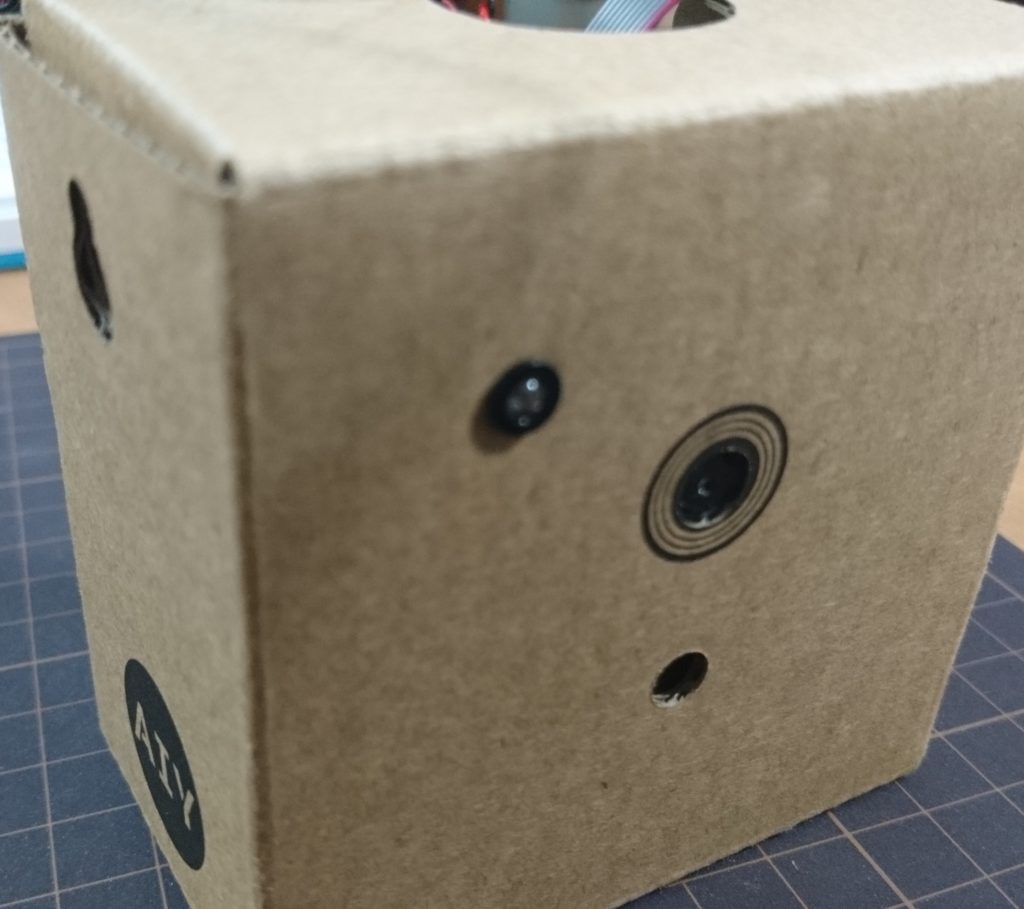

完成図は以下のような感じです。

ボタンの設置

外箱上面にボタンを配置します。

まず。ボタンの固定具に各種ケーブルを通します。

このケーブルを外箱上面の穴に通します。

通した後、ボタンに配線します。

配線は写真の左から順に、ブザーモジュール、LED、Visionモジュールです。

ボタンの配線ができたら、ボタンを外箱上面の穴にはめ、内側から固定具を回し、固定します。

ここまでできたら、外箱背面を閉じれば完成です。

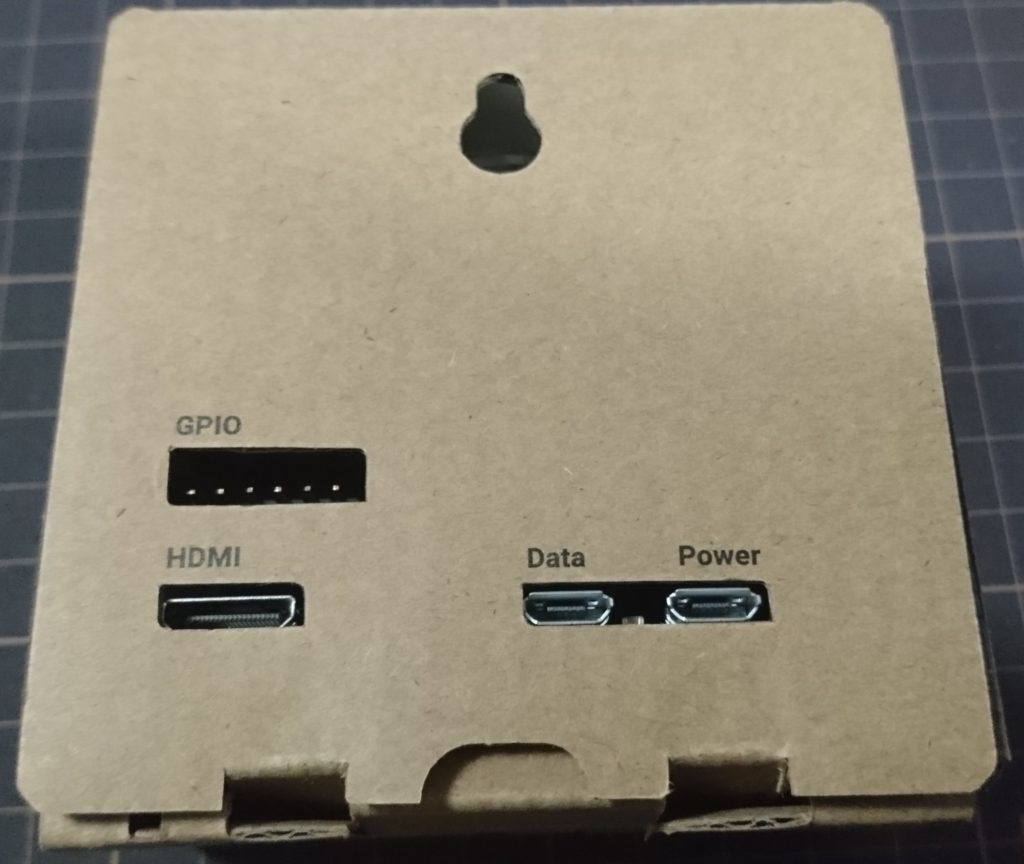

背面

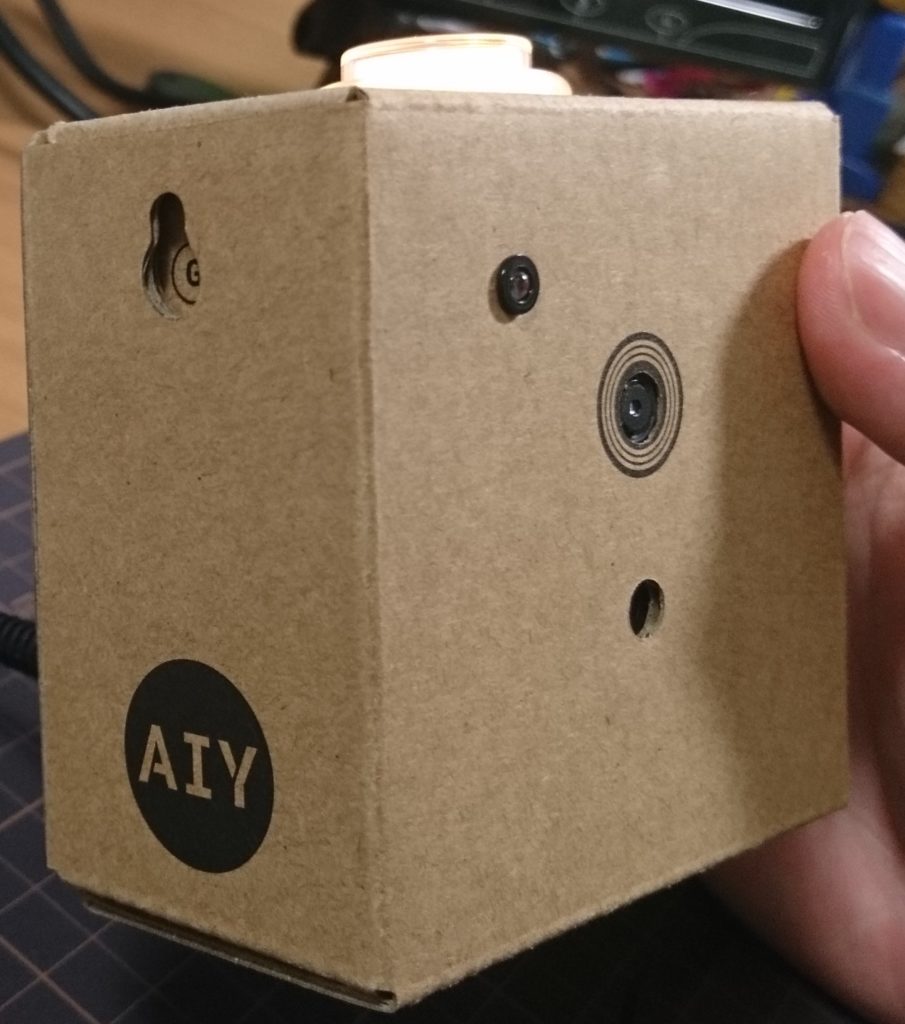

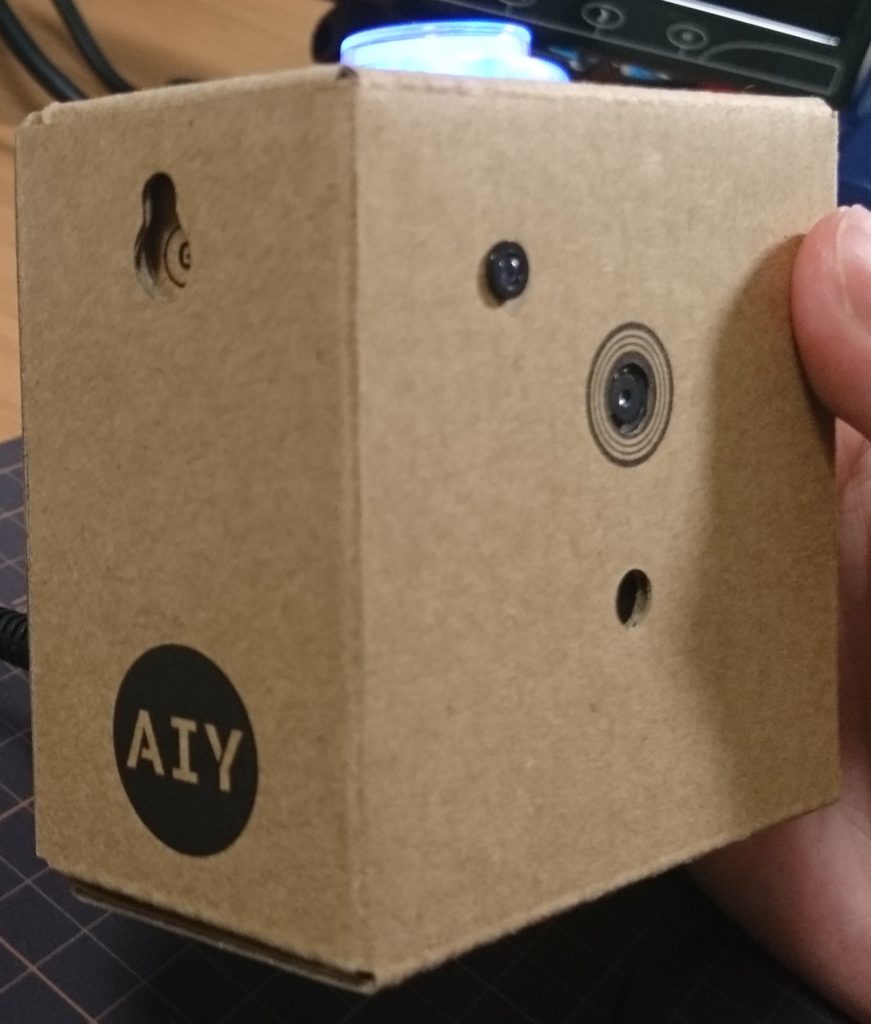

完成図

デモの動作確認

それでは、動作確認をしていきます。

動作確認の前に、キットに同梱されているSDカードをラズパイに差し込みます。

SDカードには予めOSがインストールされていますので、必ず同梱されているSDカードを利用してください。

それでは起動しましょう!

起動するにはmicroUSB端子での給電が必要です。

携帯用の充電器などがある方は、それを利用してください。

ケーブルは付属してますので、USB給電器があれば大丈夫です。

ケーブルを差し込むと、SDカードの穴から、ラズパイが光っているのがわかると思います。

光っていない場合は不具合の可能性があります。

ここはラズパイを起動しているだけなので、組み立てに失敗していても絶対に光ります。

光らないのはラズパイ自体の故障の可能性があります。

このVision KitのSDカードは、起動とともにデモプログラムが動き始めます。

ですので、すでにある画像認識プログラムが動いています。

このサンプルプログラムは、人の感情検知をするプログラムです。

試しに、Vision Kitの表面のカメラに向かって笑ってみてください。

ボタンが 橙色っぽく光ります。

逆に不機嫌そうな顔をしてみてください。

すると、ボタンが青色に光ります。

喜び検知時

不機嫌検知時

どうでしょうか?

ちゃんと感情を認識していますね。

デモプログラムの動作検証は以上です!

まとめ

いかがでしょうか?

今回は組み立ててデモを動かすまででしたが、人の感情を認識するAIを、こんな小さなデバイスで動かせました!

これはすごい技術です。

なんでも、Tensorflowで作られたディープラーニングモデルは、こののキットで動作させられるようです。

なので、オリジナルの学習済みディープラーニングモデルをVision Kitで動かすことができるみたいです!

これは試してみたくなりますよね。

まぁ私はChainer使いなのですが……

あ、TensorflowとかChainerというのは、ディープラーニングのプログラミングをするためのフレームワークというものです。

こちらも簡単な説明をいつか記事にしょうと思います。

お楽しみに。

それにしても、本当であれば、今回の記事でもうちょっと別のサンプルプログラムを動かそうと思っていました。

ちょっと前に紹介した10インチマルチモニターも、Vision Kitをつないでラズパイを動かすために買ったのです。

ですが、記事が思った以上に長くなってしまうことに気がついたので、分けることにしました。

頑張って続きも書きますので、楽しみにしていてください!

Mividiusのスティック版も記事にしたいですし、AI関連は書きたいことが多くて困ってしまいます 笑

でも、好きなことなので頑張ってやってやります!

今回の記事で少しでも気になった方はこのVision Kit試してみてください。

価格は14000円と、決して安くはないですが、これだけの価値はあります。

何せMovidiusのスティックだけで10000円以上します。

それを積んでて、ラズパイも付いて、カメラも付いて、サンプルプログラムもある。

これ以上に本格的かつお気軽にAIが試せるキットはそうそうありません!

作業で困ったときはこちらのブログに相談に来ていただいても構いませんしね!

良いAIライフを!

それでは、今回はこのへんで!

では、また次回(* ̄▽ ̄)ノ~~ マタネー♪

![[商品価格に関しましては、リンクが作成された時点と現時点で情報が変更されている場合がございます。] [商品価格に関しましては、リンクが作成された時点と現時点で情報が変更されている場合がございます。]](https://hbb.afl.rakuten.co.jp/hgb/1821601c.b576a9f1.1821601d.3e936fd4/?me_id=1255046&item_id=10012748&m=https%3A%2F%2Fthumbnail.image.rakuten.co.jp%2F%400_mall%2Ftsukumorobo%2Fcabinet%2Fimgrc0103158300.jpg%3F_ex%3D80x80&pc=https%3A%2F%2Fthumbnail.image.rakuten.co.jp%2F%400_mall%2Ftsukumorobo%2Fcabinet%2Fimgrc0103158300.jpg%3F_ex%3D128x128&s=128x128&t=picttext)

コメント